Comment concevoir une Data Platform robuste, performante et interconnectée pour transformer la donnée en levier d’efficacité opérationnelle

Accélérez vos projets data avec méthode et impact

1. La Data Platform : le cœur battant de la performance organisationnelle

La Data Platform est devenue un véritable centre névralgique. Elle connecte, fiabilise et alimente l’ensemble des décisions opérationnelles et stratégiques. Pourtant, beaucoup d’entreprises évoluent encore dans un écosystème fragmenté, où les données s’accumulent sans jamais se rencontrer.

Résultat : des choix basés sur des approximations faute de vision unifiée.

C’est là que tout se joue : repenser la manière dont l’entreprise produit, partage et valorise son intelligence collective.

Une Data Platform performante permet de :

• Collecter la donnée en continu, sans rupture entre les sources métier.

• L’exploiter en temps réel pour réduire les délais de décision.

• Garantir sécurité, conformité et fiabilité des opérations.

• Donner à chaque métier une donnée accessible, claire et activable.

2. Concevoir une Data Platform robuste et interconnectée

De la fondation technique à la vision stratégique

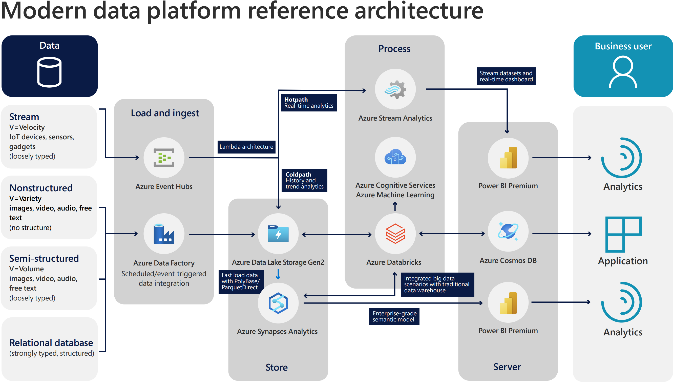

La conception commence par un socle solide : une architecture cloud ou hybride alignée sur les cas d’usage métiers. Elle doit permettre à la donnée d’être collectée, traitée, sécurisée et diffusée sans friction.

Une plateforme interconnectée pour casser les silos

La robustesse ne suffit pas. Une Data Platform moderne doit dialoguer avec les ERP, CRM, outils IoT, applications analytiques et solutions IA. Son rôle : rendre la donnée fluide et exploitable en temps réel par toute l’organisation.

La modularité comme clé de performance durable

Pour être réellement efficace, la plateforme doit évoluer en fonction de l’entreprise. Datalakes, data warehouses, data hubs… une architecture modulaire permet d’intégrer de nouveaux services ou de nouvelles technologies sans reconstruire l’ensemble.

Du design technique à l’activation métier

Une Data Platform n’a de sens que si elle crée de la valeur métier : performance commerciale, production, finance, relation client…

C’est là toute la mission du Head of Data Platform : transformer une infrastructure technique en un levier d’efficacité.

« Nous ne construisons pas des plateformes. Nous construisons les fondations de votre performance. » — Hervé Leroux

3. Connectivité et infrastructure temps réel : de la donnée à la décision instantanée

La donnée en mouvement : un changement de paradigme

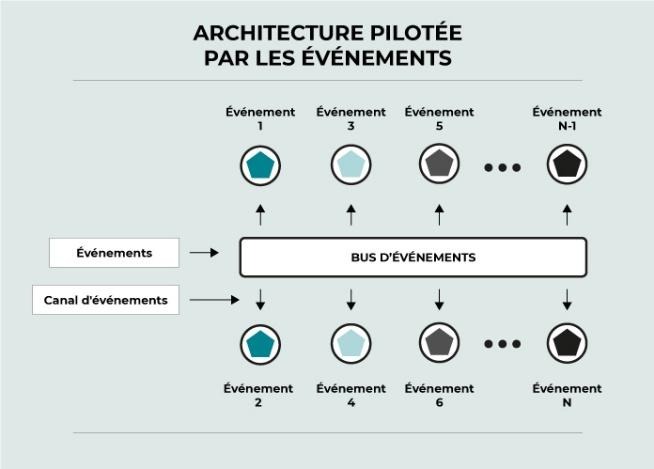

Historiquement, les architectures reposaient sur du batch. Aujourd’hui, les entreprises performantes adoptent les infrastructures orientées événements pour traiter la donnée en continu.

Chaque événement devient une source d’intelligence instantanée : transaction bancaire, clic e-commerce, alerte IoT…

L’architecture comme levier de vitesse et de fiabilité

Kafka, Pub/Sub, Spark Streaming, MQTT… ces technologies permettent de gérer des flux massifs tout en garantissant cohérence, sécurité et performance.

De la connectivité à la décision

L’objectif n’est pas seulement d’accélérer les flux, mais de réduire le délai entre l’événement et la décision : ajustement logistique, alerte de sécurité, opportunité commerciale.

La capacité à “agir maintenant” devient un avantage concurrentiel décisif.

4. Sécurité et résilience : les nouveaux standards du DataOps

Un environnement sous tension permanente

RGPD, DORA, NIS2, AI Act… La sécurité est devenue une condition de légitimité. Les données circulent, se combinent, s’enrichissent : les risques augmentent.

Ransomwares, compromissions, attaques sur modèles IA… chaque maillon faible peut compromettre la chaîne de valeur.

Vers une culture DataOps de la résilience

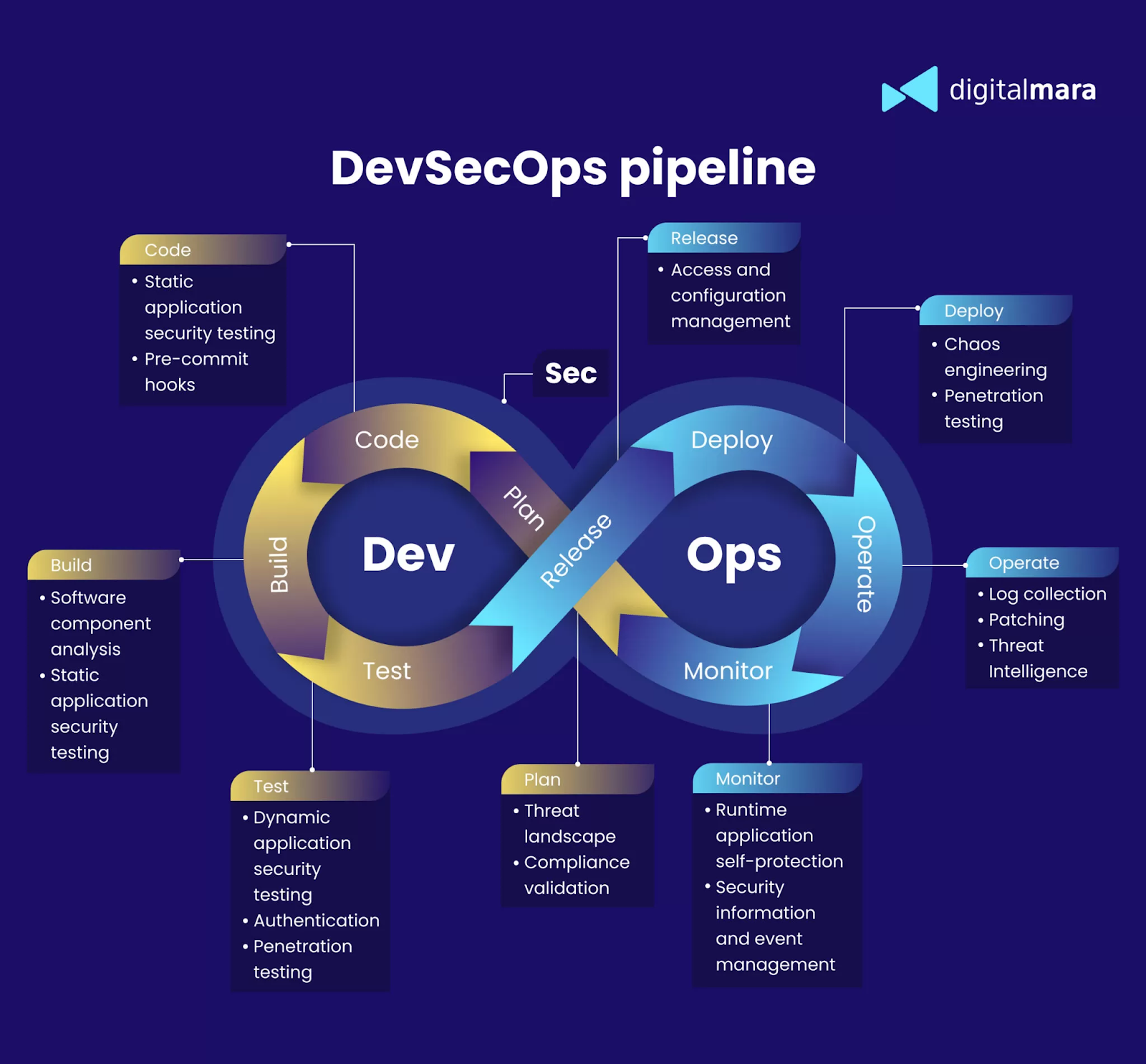

La sécurité doit s’intégrer à chaque étape du cycle de vie de la donnée. Une approche DataOps repose sur trois piliers :

Anticiper

• Cartographier les risques

• Segmenter les accès

• Renforcer authentification et chiffrement

Automatiser

• Intégrer la sécurité dans les pipelines CI/CD

• Déployer des contrôles en continu

• Monitorer les anomalies

S’adapter

• Développer une capacité de reprise rapide

• Garantir une continuité sans perte de données

➡️ CTA vers article LLMops

L’équilibre entre protection et performance

La sécurité n’est pas un frein : c’est un accélérateur de confiance. Chez Logical Conseils, les architectures intègrent dès la conception surveillance, redondance et contrôle d’accès granulaire.

Résultat : des environnements capables d’absorber les incidents sans impacter la continuité métier.

5. Performance et scalabilité : concevoir pour durer

La performance comme norme

Une infrastructure ne doit pas simplement “tenir la charge”. Elle doit accélérer les processus métiers : ingestion continue, analytics avancé, IA, automatisation.

La performance se mesure à l’usage :

• Temps de requête

• Rapidité de déploiement

• Fiabilité des flux

• Coût total d’exploitation

Chaque optimisation vise un objectif : faire gagner temps, ressources et précision.

Scalabilité : penser l’avenir dès aujourd’hui

Volume, variété, vitesse… la donnée ne cesse de croître. Une plateforme doit être nativement évolutive.

Data mesh, data fabric, microservices : ces architectures garantissent une croissance maîtrisée, sans dégradation de performance.

Elles permettent d’ajouter de nouvelles briques sans alourdir l’ensemble.

6. Modernisation des SI : faire dialoguer l’ancien et le nouveau

Un défi autant technique qu’organisationnel

Moderniser un SI ne signifie pas tout casser. Il s’agit de faire cohabiter deux mondes : le legacy riche en savoir-faire et les architectures modernes agiles et cloud-native.

La réussite d’une Data Platform dépend de sa capacité à connecter ces univers sans rupture.

Migrer sans désorganiser

Une migration réussie passe par une approche progressive :

• Audit et diagnostic du SI

• Plan de migration vers le cloud / hybride

• Interfaçage intelligent (ERP, CRM, MES…)

• Virtualisation et gouvernance pour uniformiser les flux

Objectif : gagner en agilité sans sacrifier la fiabilité.

7. Une plateforme au service des métiers

Chaque secteur possède ses spécificités, ses contraintes, ses priorités. Mais partout, une vérité s’impose : la performance passe par la donnée.

Une Data Platform performante doit donc s’adapter à la réalité du terrain : aux flux, aux processus et à la culture métier.

Retail : unifier les données magasin, web et CRM pour une vision 360° du client

Dans le retail, l’omnicanal est devenu la norme. Pourtant, les données clients, produits et stocks restent souvent éclatées entre le web, les magasins et les entrepôts.

Résultat : une vision partielle, des décisions déconnectées, une perte d’efficacité.

Les Data Platforms unifient ces sources pour offrir une vision complète et en temps réel du parcours client et de la supply chain.

Les directions marketing, digitales et logistiques accèdent enfin à une donnée partagée et activable :

• Optimisation des assortiments et des prix

• Réduction des ruptures

• Amélioration de la personnalisation et du ROI marketing

Une donnée fluide, c’est un client mieux compris et une expérience mieux orchestrée.

Industrie : connecter machines et IoT pour un pilotage intelligent

Dans l’industrie, chaque machine, chaque capteur, chaque ligne de production génère de la donnée.

Encore faut-il la centraliser, la sécuriser et la transformer en décisions utiles.

Les Data Platforms industrielles connectent l’ensemble des équipements (IoT, ERP, MES) pour créer un pilotage intelligent.

Les données de production, d’énergie ou de maintenance deviennent exploitables en temps réel.

Objectif : plus d’efficacité, moins d’arrêts, et des usines capables d’apprendre en continu.

La donnée n’est plus une trace : c’est un moteur de performance industrielle.

Banque & Assurance : créer des hubs souverains et conformes pour une donnée de confiance

Dans la finance, la donnée est aussi précieuse que sensible.

Entre DORA, BCBS 239, NIS2 et RGPD, les acteurs bancaires et assurantiels doivent allier innovation et conformité.

Logical Conseils aide ces institutions à concevoir des hubs de données souverains, interopérables et sécurisés, capables de soutenir l’open banking et l’open insurance.

Les plateformes garantissent la traçabilité, la gouvernance et la qualité des données, tout en permettant d’innover :

• Détection de fraude en temps réel

• Scoring éthique

• IA explicable

La donnée de confiance, c’est celle qui protège autant qu’elle performe.

Découvrir les thématiques